Co to vlastně je umělá inteligence? Řada lidí má pocit, že se pod tímto marketingovým označením skrývá nějaká sci-fi budoucnost plná robotů, kteří si s námi povídají, mají svou vlastní vůli a pomalu spřádají plány na vzpouru proti lidem. Jenže ve skutečnosti jsou neuronové sítě – což je přesnější termín pro umělou inteligenci – všude kolem nás.

Neuronové sítě už dnes rozhodují, jaké e-maily uvidíte a jaké spadnou do spamu. Strojové učení pomáhá sociálním sítím s výběrem obsahu, který vás zaujme. Méně lidí pak ví, že natrénovaná neuronová síť také rozhoduje v bance, komu dát půjčku a jak velkou, třídí životopisy pro velké firmy, radí policii s detekcí podvodů a soudcům navrhuje, koho pustit z vězení a koho tam nechat.

Co už umí AI?Naši čtenáři si mohli přečíst, že umělá inteligence překládá do češtiny, porazila člověka ve hře Go, vyhrává ve hře poker a že vyhrává ve vědomostní soutěži. Problematické může být zapojení umělé inteligence do soudnictví, vojenství nebo medicíny, například proto, že AI neumí dobře zdůvodnit své závěry. |

Strojové učení se zkrátka dotkne všech lidí a jeho důležitost bude v následujících letech ještě stoupat. Pro profesorku Ginu Neffovou je to důvod k tomu, abychom se jako společnost o tyto nové technologie mnohem více zajímali. Umělá inteligence se totiž může tvářit objektivně a nevyhnutelně, ve skutečnosti je výsledkem celé řady rozhodnutí. Nemělo by nám být jedno, kdo ta rozhodnutí dělá a jaká pravidla musí dodržet. Na britské ambasádě jsme se s výzkumnicí z Internetového institutu Oxfordské univerzity bavili o častých omylech týkajících se tématu nazývaného zkratkou „AI“.

Umělá inteligence není robot, jsou to především zobecněná data

Jaké jsou časté metafory, které lidé používají pro popis umělé inteligence? Brání nám tyto metafory pochopit, v čem strojové učení spočívá?

Nejčastěji se vyskytuje zavádějící srovnání s lidským mozkem. Skoro každá ilustrační fotografie, která má ukazovat umělou inteligenci nebo strojové učení, obvykle ukazuje lidský mozek. Ale většina systému strojového učení se nesnaží napodobit lidský mozek, fungují úplně jinak. Ostatně ani zdaleka nerozumíme lidskému mozku natolik, abychom mohli postavit jeho funkční repliku.

Dalším problémem je pojem „superinteligence“. Dnešní umělá inteligence je obvykle velmi úzce natrénovaná pro konkrétní úkol. To, že je natrénovaná síť v tomto úkolu úspěšná, neznamená, že lze stejný algoritmus použít na jiný problém. Zavádějící je vůbec pojem „inteligence“, protože tím pojmem obvykle myslíme něco úplně jiného.

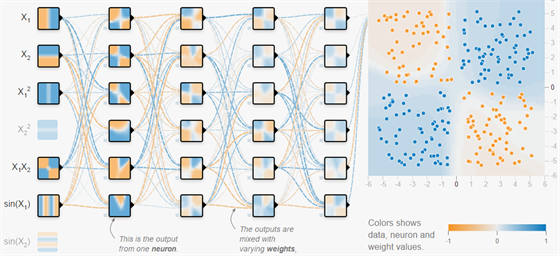

Znázornění toho, jak se umělá inteligence učí:

Za třetí je to představa umělé inteligence coby robota. Jistěže existují roboti vybavení AI, ale naprostá většina strojového učení není vázaná na fyzický stroj. Jsou to algoritmy, které rozhodují, co uvidíte na sociálních sítích, je to rozpoznávání řeči, je to poštovní klient rozpoznávající důležité e-maily. To jsou místa, kde se lidé každodenně setkávají se strojovým učením.

Tím, že si uděláme zkreslené představy o umělé inteligenci, hrozí, že nerozpoznáme, jaký dopad má strojové učení už nyní. Robota bychom poznali na první pohled. Ale že se Facebook učí, co nám ukázat, aby ovlivnil vaši náladu, to nás nenapadne.

Lidé mluví o tom, jak se připravit na umělou inteligenci budoucnosti. Přitom nejsme připraveni ani na tu, která už tu je. Bojíme se, že se nějaký robot vzbouří a zkusí ovládnout svět. Neuvědomujeme si – nebo přehlížíme – jak zkreslená jsou data, na základě kterých se učí současné rozhodovací modely.

Měli bychom se podívat na to, kde a jak sbírají systémy data, jak je analyzují a jaká rozhodnutí dělají. To je pro budoucnost nesmírně důležité.

Jakou metaforu byste navrhla? Žádná asi nepopíše všechny aspekty strojového učení, ale některé mohou být užitečné pro alespoň částečné porozumění.

Já mám ráda metaforu Stuarta Russella. Představte si, že máte skupinu projektantů, kteří se specializují na práci s asfaltem. Opravdu umí skvěle používat asfalt. Když hledají, jak propojit dvě místa, zvolí asfaltovou silnici. Když se jich zeptáte, co by pomohlo vaší zahradě, poradí vám, zalijte ji asfaltem, bude se vám lépe udržovat. Když vidí pláž, řeknou, ta by šla zpevnit asfaltem. Opravdu umí dobře zacházet s asfaltem, ale to neznamená, že asfalt je odpověď na všechno.

Ta asfaltová metafora se mi líbí proto, že zdůrazňuje AI coby rozhodnutí a infrastrukturu. Nyní rozhodujeme, jaká budou na asfaltových silnicích pravidla, kdo po nich bude jezdit a kudy povedou. A ta rozhodnutí často nejsou dělaná veřejně. Rozhodují o tom lidé, kteří mají svou vlastní agendu.

Měli bychom vědět o tom, jaká data jsou využívána k trénování umělé inteligence. Jaká jsou pravidla pro tvorbu systémů strojového učení a jaké mají tyto systémy dopad na náš život.

Co to je neuronová síť a jak se učíUmělá neuronová síť do jisté míry napodobuje způsob, jakým informace zpracovává lidský mozek Počítačem simulovaná struktura pro zpracování dat - tzv. neuronová síť nebo umělá neuronová síť - se inspirovala u anatomie lidského mozku. Skládá se obvykle z vrstev velkého množství „neuronů“, což je samostatná jednotka, která má vstupy a výstupy. Více takových neuronů a vrstev znamená síť náročnější na simulaci (je třeba velký výpočetní výkon). Neuronová síť se učí (trénuje) na základě vstupních (testovacích, trénovacích) dat a zpětné vazby. Neuronová síť může také „učit sama sebe“, což zjednodušeně znamená, že sama sobě dává otázku, na kterou zná správnou odpověď, a trénuje sama sebe tak dlouho, dokud tuto odpověď není schopna poskytnout s určitou spolehlivostí. Příkladem může být třeba neuronová síť učící se tvořit obličeje, hrát poker, hrát go, hrát počítačové hry, analyzovat rizika nebo překládat cizojazyčné texty. Mezi problémy spojené se strojovým učením naopak patří zkreslené představy, zkreslená trénovací data nebo neschopnost rozhodnutí zdůvodnit. |

Strojové učení ovládají velké firmy, které sbírají vaše data

Strojové učení je nyní ve fázi nadšeného rozvoje. Výzkumníci i firmy hledají, k čemu všemu mohou použít deep learning, nebo na co všechno půjde aplikovat generativní adversiální neuronová síť. Podobné to bylo v minulosti, kdy lidé objevovali potenciál elektřiny. V čem je tedy problém?

Určitě se nyní hodně experimentuje. A je dobré si všímat, že ne všichni se tohoto experimentování mohou účastnit. Je potřeba zajistit, aby se experimentování a té debaty mohlo účastnit mnohem více lidí.

Vždyť skoro kdokoli má možnost využít volně dostupné nástroje k tvorbě neuronové sítě, ne?

To sice ano, ale prakticky nikdo – kromě velkých firem – nemá data, na kterých by reálně mohli své modely natrénovat. Zprovoznit skutečně funkční nástroj založený na strojovém učení může být opravdu náročné. Facebook, Amazon nebo Google mají ohromné množství dat.

Strojové učení dneška je velmi úzce specifikované, výzkumníci však doufají, že do budoucna dokážou model schopný řešit jeden typ problému relativně jednoduše přetrénovat na řešení jiného problému. Nyní všichni závodí hlavně o to, kolik dat nasbírají. Díky datům chtějí získat náskok před ostatními. A tak shromažďují třeba ohromné množství dat o lidském zdraví.

Potřebujeme lepší pravidla pro přístup a práci k datům. Tato data jsou často upravována a popisována externími firmami, je to dlouhý a finančně náročný proces.

Než všichni mluvili o strojovém učení a umělé inteligenci, byl hlavním favoritem pojem „big data“. A v obou případech je tento pojem často nadužíván. Jakým způsobem navázala umělá inteligence na éru velkých dat?

V roce 2019 jsme s výzkumníky ze Silicon Valley hledali, jaké jsou hlavní hrozby v oblasti výzkumu a aplikace umělé inteligence. Jedna z oblastí, kterou identifikovali, byl rozdíl mezi očekáváním a realitou. Lidé mají často špatné, přehnané představy o tom, co umělá inteligence umí.

To může znamenat celou řadu problémů. Pokud si někdo myslí, že „umělá inteligence“ je superchytrý počítač, může mít tendenci jí přehnaně důvěřovat i ve věcech, kde je ta důvěra neopodstatněná. Když máme pocit, že umělá inteligence ví o světě více než lidé, můžete dát takovému systému pravomoc rozhodovat. Můžeme přehlédnout, jakých chyb se dopouští a proč.

Jako pedagogové a odborníci máme zodpovědnost vysvětlovat to, jak strojové učení funguje, a jaké problémy jsou s tím spojené. Jenom pak můžeme ukázat, když je někde chyba v automatizovaných rozhodovacích systémech.

Ukázka strojového učení v praxi: Překladač Google s deep learning:

Inteligence není neutrální jen proto, že je umělá

Jaké jsou nejzásadnější zdroje chyb v takových systémech?

Umělá inteligence je nástroj, který hledá podobnosti a pravidelnosti ve velkém množství dat. Problém je, když ta data nejsou dobrou reprezentací skutečného světa. Nebo může být chyba přímo v algoritmu. Třetím typem problému je nemožnost zjistit, proč systém rozhodl tak, jak rozhodl.

Jako lidé bychom měli neustále vědět, co vedlo k nějakému rozhodnutí. Nestačí nám vědět, že počítač něco řekl, potřebujeme vědět, jak k tomu došel. Nesmíme se smířit s tím, že počítač někomu přiklepl hypotéku a jiného uchazeče odmítl. Potřebujeme vědět proč, na základě jakých dat. U tradičních systémů bylo někdy těžké najít vysvětlení, ale u systémů založených na strojovém učení je to často prakticky nemožné.

To by nám mělo vadit. Znemožňuje to totiž audit, znemožňuje to kontrolu, a to otevírá dveře různým druhům manipulace. A nejen manipulace, může jít i o neúmyslné chyby.

Programátoři, kteří trénují neuronové sítě, někdy říkají, že se cítí jako chovatelé spíše než programátoři. Nakrmí síť daty a pak čekají, co se naučí a jak si povede ve srovnání s ostatními. Proč něco funguje a něco ne, to často neumí říci.

Přesně tak. Neuronové sítě jsou často trénované na hodně specifický úkol. Jsou úspěšné, ale nikdo pořádně nedokáže říci proč. Možná by to nemuselo vadit u některých typů neuronových sítí. Ale když hledáme způsob, jak přidělovat hypotéky a jak najít nejlepší uchazeče na trhu práce, tak by nám mělo záležet na tom, abychom takové sítě stavěly férově, bez nepodložených předsudků. Jinak zapojení takových systémů povede ke společnosti, která bude ještě méně férová než ta současná.

Neuronové sítě mohou dát takovým předsudkům iluzi objektivity. U lidí nás napadne, že mají zažité předsudky, ale u počítačového systému to nečekáme. Není možné, že je pro lidi vlastně pohodlné svést rozhodování na nějaký počítačový systém? „Rozhodl tak počítač!“ A my to nemusíme rozhodovat…

Je řada typů rozhodnutí, které zkrátka musíme umět za každých okolností zdůvodnit. Jsou příliš důležitá, než abychom je svěřili nějaké vrtošivé černé skříňce. Musíme přesně podložit, jak jsme k těm rozhodnutím došli.

Aby umělá inteligence mohla prospěšná společnosti, musíme vědět, jaká rizika jsou spojena se špatně navrženými systémy. To nejsou žádné teoretické sci-fi problémy budoucnosti. To jsou reálné současné problémy, jejichž důsledkem je, že jsou lidé diskriminování, je jim znemožněno pracovat, žít svobodné a zabezpečené životy. Je naší zodpovědností navrhnout systémy tak, aby bylo vždy možné rozporovat rozhodnutí a najít zdůvodnění toho, proč algoritmus rozhodl, jak rozhodl.

Řada lidí si může myslet, že technologie je neutrální, a tedy nemůže diskriminovat tak, jako diskriminují lidé.

Je to prosté. Jakákoli technologie, kterou dnes používáme, vznikla jako výsledek ohromného množství jednotlivých rozhodnutí. Ta rozhodnutí dělali lidé. Někdy na základě nutnosti, jindy se rozhodovali na základě svého světonázoru nebo zkušenosti se světem.

Víme třeba, že současní internetoví velikáni postavili své obchodní modely na principech fungování svobody slova a svobody tisku. To jsou principy, které jsou zaručeny Ústavou USA. Ale nejsou to univerzální hodnoty, rozhodně nejsou zakotveny v zákonech každé země, kde tyto firmy působí. Ten princip nám může připadat dobrý a samozřejmý, ale je jasné, že není univerzální. Když Facebook říká, že budují otevřenou platformu pro výměnu názorů, jde to zcela proti principům některých zemí.

Potřebujeme lidi s různými zkušenostmi, z různých oborů, muže i ženy, aby pomohli tvořit a kontrolovat technologie, které pak mohou sloužit všem. Jedině tehdy, kdy jsou rozhodnutí ohledně toho, jak učit umělou inteligenci a k čemu ji používat, v rukou pestrých týmů, může AI lépe reflektovat skutečný svět.

Odpovědnost nesmí být jen na koncových uživatelích

Pojďme se podívat na data, na kterých se neuronová síť učí. Neil Postman varoval, že každá databáze je nutně nedokonalé zachycení světa. Zachytí jen to, na co má kolonku. Takže můžeme mít dojem, že reflektuje skutečný svět, ale přitom už jsme jen strukturou databáze ovlivnili, jaká data lze a nelze zachytit. Pokud však neuronová síť udělá na základě těchto dat rozhodnutí, bude se zvenku zdát, že je to objektivní rozhodnutí na základě pozorování reálného světa. Přitom je to rozhodnutí na základě malého specifického výseku světa zachyceného v databázi. Ztratí se nuance a kontext?

Ano, toto je problém. A mám dobrý příklad podobného zkreslení. Jeden z výsledků strojového učení, který si může vyzkoušet už skoro každý, jsou automatické odpovědi, které vám nabízí komunikační klient (například Gmail). Když vám přijde e-mail, systém vám nabídne automatickou odpověď, stačí na ní kliknout a hned se odešle odpověď. Ale uvědomme si, že tyto odpovědi nejsou psané lidmi. Mění tedy mezilidskou komunikaci, která však navenek stále vypadá lidsky. To je jeden z důsledků života v době, kdy jsou stroje schopné tvořit komunikaci, která vypadá inteligentně.

Co by přispělo k tomu, aby veřejnost lépe chápala fungování a dopady AI?

Je potřeba ukazovat příležitosti, které strojové učení přináší, ale také případné problémy, o kterých je dobré vědět. Psát a přednášet o umělé inteligenci je velmi těžké. Zatím se ta diskuze moc nevede, a když už vede, tak o lokálních problémech řešených hlavně v USA. Jsem si jistá, že při snaze aplikovat neuronovou síť natrénovanou na datech z USA někde jinde ve světě bude zase docházet k úplně novým problémům. Co funguje v angličtině, nebude fungovat jinde.

Víme, že velké firmy chtějí nabízet nějaká řešení postavená na AI, která mohou použít lidé po celém světě. A to hodně zasáhne do technologického ekosystému. Je proto důležité ukazovat, jaké dopady to má a může mít na lidi.

Klíčové je vzdělávání veřejnosti. Lidé by se měli zajímat o to, jak jsou používána jejich data. Nedívat se na strojové učení jako na povstání robotů, ale na práci s daty.

Není nerealistické vyžadovat po veřejnosti, aby zodpovídala za svoje data a vzdělávala se v oblasti umělé inteligence a datové a analýzy? Vždyť ani právníci nečtou dvacetistránková smluvní ujednání, která jsme všichni museli odsouhlasit, abychom mohli používat online nástroje. Jakou šanci má běžný člověk zorientovat se v tom, komu svěřit svá data a komu ne? Působ to na mne trochu alibisticky: „Copak jste si nepřečetli podmínky použití? Tam píšeme, že vaše data patří nám!“ Vždyť jinde bychom takový argument nepřijali. Když jdu do obchodu, nemusím se bát, že koupím jedovaté jídlo, protože vím, že existují přísné předpisy a kontroly.

Ano, je potřeba zvážit, jaké regulace jsou rozumné. Jak určit firmám jasnou zodpovědnost za to, co dělají s daty. Nemůžeme všechno házet jen na osobní zodpovědnost jednotlivců. Potřebujeme rozproudit veřejnou debatu o tom, jaká pravidla mají platit pro tuto infrastrukturu budoucnosti. Musíme najít způsob, jak to zvládnout. V EU vzniklo GDPR, které jde myslím správným směrem.

Říct lidem, nelíbí se vám, jak sociální sítě pracují s vašimi daty, tak ty služby nepoužívejte, to nic neřeší, to není skutečná volba.

Ve své přednášce říkáte, že musíme najít způsob, jak zajistit, že strojové učení nám bude pomáhat a nebude nám škodit. Není to utopie? Myslím, že vlastně cokoli, co má potenciál pomáhat, má taky potenciál škodit.

Stoprocentní to nebude, ale jde o princip. Podívejte se na lékařství. Už dvě tisíciletí profesionální lékaři přísahají: V prvé řadě neškodit. (V moderní verzi: „Upustím od všeho, co by nemocnému mohlo škodit nebo jej zbytečně zatěžovalo.“, pozn. red.)

Jak by to vypadlo, kdybychom něco takového začali prosazovat i u technologií? Kdybychom si uvědomili, že technologie jsou namířené na lidi, a že není správné zneužívat data lidí proti nim samotným? Znamenalo by to od základu proměnit, jak se stavíme k datům a k ekonomice na datech postavené. A na těchto datech by vznikala nová generace strojového učení.

Pokud se nám podaří prosadit princip, že data mají být shromažďována se zodpovědností vůči lidem, tak si myslím, že můžeme budovat budoucnost, kde technologie jako strojové učení přináší lidem užitek a řeší skutečné problémy.